Lineaarne regressioon: definitsioon, meetodid ja praktilised näited

Tutvu lineaarse regressiooniga: definitsioon, peamised meetodid (vähimad ruudud, ridge jne) ja praktilised näited prognoosimiseks ja andmeanalüüsiks.

Lineaarne regressioon on viis selgitada sõltuva muutuja ja ühe või mitme selgitava muutuja vahelist seost, kasutades selleks sirgjoonelist mudelit. Tavapärane matemaatiline vormiks on

y = β0 + β1 x1 + ... + βp xp + ε, kus y on sõltuv muutuja, x1,...,xp on selgitavad muutujad, β0,...,βp on mudeli parameetrid ja ε on juhuslik viga. Lineaarne regressioon on üks regressioonanalüüsi erijuhtudest ja sageli esimene valik seose kvantifitseerimiseks või ennustuseks.

Lineaarset regressiooni uuriti ajalooliselt põhjalikult osaliselt seetõttu, et mudeleid, mis sõltuvad lineaarselt oma tundmatutest parameetritest, on lihtsam sobitada ja nende hinnangute statistilisi omadusi analüüsida. See ei tähenda, et lineaarne regressioon sobib alati — oluline on kontrollida eelduste täitumist ja valida sobiv meetod vastavalt andmetele.

Peamised rakendused

- Ennustamine ja prognoosimine: lineaarset regressiooni kasutatakse mudeli kohandamiseks vaadeldud andmetele, et hiljem antud uute selgitavate muutujate põhjal ennustada sõltuva muutuja väärtusi. Kui pärast mudeli väljatöötamist antakse uus X-vaatlus ilma vastava y-väärtuseta, saab mudelit kasutada y prognoosimiseks.

- Seoste hindamine ja muutujate valik: arvestades y-d ja mitmeid X1,...,Xp, saab lineaarset regressiooni kasutada selleks, et kvantifitseerida y ja iga Xj vahelise seose tugevust, hinnata, millised Xj on seotud y-ga, millised mitte, ning tuvastada alamhulgad, mis annavad üleliigset või mittesignaalset informatsiooni.

Hinnangumeetodid

Lineaarsete regressioonimudelite puhul püütakse üldjuhul vähendada joone ja andmepunktide vahelist vertikaalset kaugust. Kõige levinum on vähimad ruutud (ordinary least squares, OLS), mille energiaks on jääkide ruutude summa minimeerida (vähimad ruutud). OLS-i eeliseks on lihtsus ja hea teoreetiline käitumine eelduste korral.

Lisaks OLS-ile kasutatakse ka teisi lähenemisi:

- Maksimum tõenäosuse meetod — eeldusel, et jäägid on normaaljaotusega, langeb see tihti kokku OLS-iga, kuid võimaldab lihtsamalt laiendada probabilistlikele mudelitele.

- Karistatud meetodid — nagu ridge- või LASSO-regressioon, kus minimeeritakse jääkide ruutude kadumisfunktsiooni karistatud versiooni, et vähendada üleõppimist ja lahendada multikollineaarsust.

- Robustsed meetodid — et vähendada mõju äärmuslikest vaatluste (outliers) või heteroskedastilisuse korral (nt vähimate absoluutsete kõrvalekallete regressioon).

Eeldused ja diagnostika

Lineaarse regressiooni tõlgendamiseks ja usaldusväärsete järelduste tegemiseks tuleb tavaliselt kontrollida järgmisi eeldusi:

- Lineaarne seos: oodatud y- ja X-suhete tinglik keskmine on lineaarne.

- Independentsus: jäägid on sõltumatud (eriti järjestikuste mõõtmiste korral kontrollitakse autokorrelatsiooni, nt Durbin–Watson testiga).

- Homoskedastilisus: jääkide dispersioon on konstantne kõikide X väärtuste puhul. Heteroskedastilisuse korral võib kasutada robustseid standardvigu või kaalutud vähimaid ruute.

- Normalne jääkide jaotus: eelkõige oluliseks statistikate (nt t-testide) õigsuse jaoks väikeste valimite korral; suurte valimite puhul tagab keskväärtusteoariik asümptootika.

- Puutumatuse probleemid: multikollineaarsus (selgitajate kõrge omavaheline korrelatsioon) raskendab parameetrite eristamist — selle tuvastamiseks kasutatakse VIF (variance inflation factor) ja leevenduseks ridge- või aluselise valiku meetodeid.

Diagnostika tööriistadena kasutatakse jääkide ja kohandatud väärtuste (residuals vs fitted) graafikuid, QQ-ploti, Cooki kaugust ja leverage-statistikaid, samuti spetsiaalseid teste (näiteks Breusch–Pagan heteroskedastilisuse test). Mõõdetakse ka mudeli selgitusvõimet R² ja korrigeeritud R² abil.

Hindamine ja interpretatsioon

- Parameetri hinnangud: koefitsiente tõlgendatakse kui keskmist muutust sõltuvas muutujas, kui kõiki teisi muutujaid hoitakse konstantsetena (nt β1 näitab, kui palju y muutub ühe ühiku võrra x1 kasvu korral).

- Usaldusvahemikud ja testid: standardvead, t-statistikad ja p-väärtused võimaldavad hinnata, kas koefitsiendid on statistiliselt erinevad nullist.

- R² ja korrigeeritud R²: R² näitab, kui suur osa y variatsioonist on mudeliga seletatav; korrigeeritud R² arvestab selgitajate arvu ja sobib võrdlusteks erinevate mudelite vahel.

- Ennustused: mudelilt saadakse punktennustused, aga ka prognoosi usaldusintervallid (wider) ja koefitsientide usaldusintervallid. Ennustuste hälvet mõjutavad nii parameetrite hinnangu viga kui ka juhusliku vea hajuvus.

Lihtne näide

Lihtsas lineaarses regressioonis ühe selgitajaga (simple linear regression) on mudel yi = b0 + b1 xi + ei. Vähimruutude lahendused lihtsustatult:

b1 = Σ(xi - x̄)(yi - ȳ) / Σ(xi - x̄)²

b0 = ȳ - b1 x̄

Praktiline näide: kui uurida palku sõltuvalt töökogemusest, siis b1 näitab, kui palju palka keskmiselt juurde tuleb ühe lisatud tööaasta kohta, kui kõik muu on võrdne.

Praktilised näpunäited

- Skaleeri ja tsentreeri muutujad (keskmise mahaarvamine, standardiseerimine), eriti kui kasutate karistatud meetodeid või suhtlete muutujatega.

- Kasutage dummy-muutujaid kategooriliste tunnuste jaoks ja mõelge interaktsioonidele, kui mõju ei ole additiivne.

- Hinnake mudeli üldistatavust ristvalideerimise (cross-validation) abil enne, kui mudelit laialt rakendate ennustamiseks.

- Kui eeldused ei kehti, proovige transformatsioone (log, Box–Cox), kaalutud vähimaid ruute või robustseid hinnanguid.

Kokkuvõte

Lineaarne regressioon on lihtne, paindlik ja tihti informatiivne meetod seoste modelleerimiseks ja prognoosimiseks. Kuigi sageli kasutatakse vähimaid ruute sobitamiseks, on olemas mitmeid alternatiive ja täiustusi (robustsed meetodid, ridge, LASSO jpm), mis aitavad lahendada praktilisi probleeme nagu heteroskedastilisus ja multikollineaarsus. Nagu eespool mainitud, on mõisted "vähimad ruutud" ja "lineaarne mudel" tihedalt seotud, kuid need ei ole sünonüümid — vähimad ruutud on vaid üks paljudest sobitamisstrateegiatest.

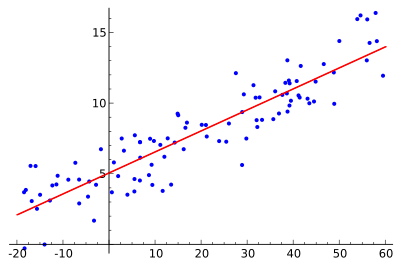

Idee on leida punane kõver, sinised punktid on tegelikud proovid. Lineaarse regressiooniga saab kõik punktid ühendada ühe sirgjoonega. Selles näites kasutatakse lihtsat lineaarset regressiooni, kus punase joone ja iga proovipunkti vahelise kauguse ruutu minimeeritakse.

Kasutamine

Majandus

Lineaarne regressioon on peamine analüüsivahend majandusteaduses. Näiteks kasutatakse seda tarbimiskulutuste, püsiinvesteeringute kulutuste, varuinvesteeringute, riigi ekspordi ostude, impordikulutuste, likviidsete varade nõudluse, tööjõunõudluse ja tööjõupakkumise prognoosimiseks.

Küsimused ja vastused

K: Mis on lineaarne regressioon?

V: Lineaarne regressioon on viis, kuidas vaadata, kuidas midagi muutub, kui teised asjad muutuvad, kasutades matemaatikat. See kasutab sõltuvat muutujat ja ühte või mitut selgitavat muutujat, et luua sirgjoon, mida nimetatakse "regressioonijooneks".

K: Millised on lineaarse regressiooni eelised?

V: Mudeleid, mis sõltuvad lineaarselt oma tundmatutest parameetritest, on lihtsam sobitada kui mudeleid, mis on oma parameetritest mittelineaarselt sõltuvad. Lisaks on saadud hinnangute statistilisi omadusi lihtsam määrata.

K: Millised on lineaarse regressiooni praktilised kasutusalad?

V: Lineaarset regressiooni saab kasutada prognoositava mudeli sobitamiseks vaadeldavatele väärtustele (andmetele), et teha prognoose, prognoose või vähendamisi. Seda saab kasutada ka muutujate vaheliste seoste tugevuse kvantifitseerimiseks ja selliste andmete alamhulkade kindlakstegemiseks, mis sisaldavad üleliigset teavet mõne teise muutuja kohta.

K: Kuidas püütakse lineaarsete regressioonimudelite abil vähendada vigu?

V: Lineaarsed regressioonimudelid püüavad teha vertikaalset kaugust joone ja andmepunktide (jääkide) vahel võimalikult väikeseks. Seda tehakse kas jääkide ruutude summa (väikseimad ruudud), sobimatus mõne muu normi (väikseimad absoluutsed kõrvalekalded) või väikseima ruutude kadumisfunktsiooni karistatud versiooni (ridge regressioon) minimeerimise teel.

Küsimus: Kas on võimalik, et lineaarse regressiooni mudelid ei põhine vähimatel ruutudel?

V: Jah, on võimalik, et lineaarsete regressioonide mudelid ei põhine vähimad ruutude meetodil, vaid kasutavad selle asemel selliseid meetodeid nagu sobimatuse puudumise minimeerimine mõnes muus normis (vähimad absoluutsed kõrvalekalded) või vähimad ruutude kadude funktsiooni karistatud versiooni (ridge regressioon) minimeerimine.

Küsimus: Kas "lineaarne mudel" ja "vähimad ruutud" on sünonüümid?

V: Ei, need ei ole sünonüümid. Kuigi need on omavahel tihedalt seotud, viitab "lineaarne mudel" konkreetselt sirgjoone kasutamisele, samas kui "vähimad ruutud" viitab konkreetselt sellele, et püütakse minimeerida vigu, tagades, et sirgjoone ja andmepunktide vahel on minimaalne vertikaalne kaugus.

Otsige